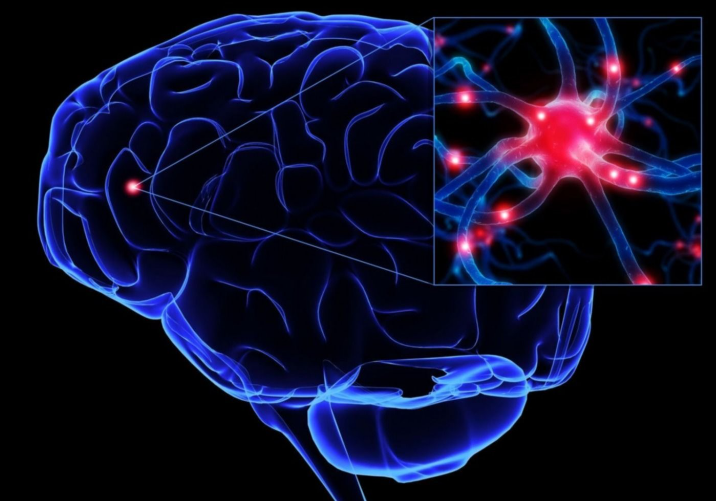

¿Una IA puede decodificar el habla de la actividad cerebral?

Una inteligencia artificial puede decodificar palabras y oraciones a partir de la actividad cerebral con una precisión sorprendente, pero aún limitada. Usando solo unos segundos de datos de actividad cerebral, la IA adivina lo que una persona ha escuchado; enumera la respuesta correcta entre sus 10 posibilidades principales hasta en un 73 por ciento de las veces, según encontraron los investigadores en un estudio preliminar.

Desarrollada en la empresa matriz de Facebook, Meta, la IA podría eventualmente usarse para ayudar a miles de personas en todo el mundo que no pueden comunicarse a través del habla, el teclado o los gestos, eso incluye a muchos pacientes en estados mínimamente conscientes, encerrados o vegetativos, lo que ahora se conoce generalmente como síndrome de vigilia que no responde.

La mayoría de las tecnologías existentes para ayudar a esos pacientes a comunicarse requieren cirugías cerebrales riesgosas para implantar electrodos, pero este nuevo enfoque podría proporcionar un camino viable para ayudar a los pacientes con déficits de comunicación sin el uso de métodos invasivos, según neurocientíficos. Investigadores entrenaron una herramienta computacional para detectar palabras y oraciones en 56.000 horas de grabaciones de voz de 53 idiomas; la herramienta, también conocida como modelo de lenguaje, aprendió a reconocer características específicas del lenguaje tanto en un nivel de grano fino (piense en letras o sílabas) como en un nivel más amplio, como una palabra o una oración.

El equipo aplicó una IA con este modelo de lenguaje a las bases de datos de cuatro instituciones que incluían la actividad cerebral de 169 voluntarios. En estas bases de datos, los participantes escucharon varias historias y oraciones de, por ejemplo, El viejo y el mar de Ernest Hemingway y Las aventuras de Alicia en el país de las maravillas de Lewis Carroll mientras se escaneaban los cerebros de las personas mediante magnetoencefalografía o electroencefalografía, esas técnicas miden el componente magnético o eléctrico de las señales cerebrales.

Luego, con la ayuda de un método computacional que ayuda a explicar las diferencias físicas entre los cerebros reales, el equipo trató de decodificar lo que los participantes habían escuchado, utilizando solo tres segundos de datos de actividad cerebral de cada persona. El equipo instruyó a la IA para que alineará los sonidos del habla de las grabaciones con los patrones de actividad cerebral que la IA calculó como correspondientes a lo que la gente escuchaba, luego hizo predicciones sobre lo que la persona podría haber estado escuchando durante ese corto tiempo, dadas más de 1,000 posibilidades.

Usando magnetoencefalografía, o MEG, la respuesta correcta estuvo entre las 10 mejores conjeturas de la IA hasta en un 73 por ciento de las veces, encontraron los investigadores. Con la electroencefalografía, ese valor se redujo a no más del 30 por ciento.

Responses